Detailbeschreibung

AUSGANGSLAGE

Der Einsatz von Sprachmodellen (LLM) stellt Unternehmen vor zahlreiche Entscheidungen. Welches LLM soll ausgewählt, für welche Aufgaben soll es eingesetzt und wie kann sichergestellt werden, dass der generierte Output den Anforderungen entspricht?

Da sie nicht-deterministisch sind, führen exakt gleiche Prompts zu verschiedenen Zeitpunkten i.d.R. zu unterschiedlichen Ausgaben. Darüber hinaus können LLM halluzinieren oder dazu gebracht werden, schädlichen Output zu generieren. Es gibt also viele Gründe, warum eine kontinuierliche Überwachung von LLM unabdingbar ist.

LÖSUNGSANSATZ

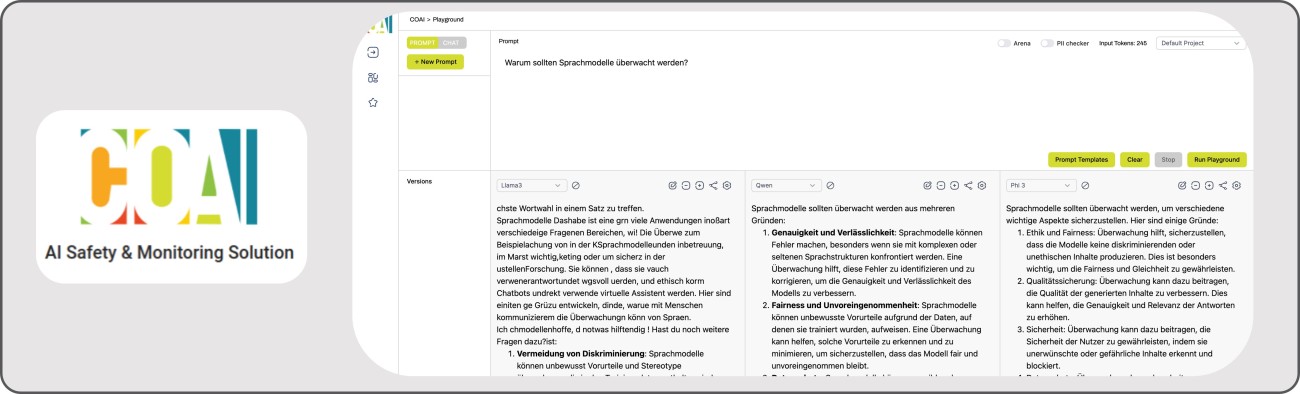

- Für die Entwicklung von LLM-basierten Applikationen und deren Einführung in Unternehmen bietet die Plattform COAI einen E2E-Ansatz für die Evaluierung, das Tracking und das Monitoring von Sprachmodellen.

- Verschiedene Sprachmodelle können in einem Playground direkt miteinander verglichen und evaluiert werden.

- Durch eine Protokollierung der Interaktionen mit und in einem LLM können Informationen über die Nutzung, Kosten, Latenz, Fehlerraten, Akzeptanz gesammelt werden. Darüber hinaus dient die Sammlung von Input/Output Daten zu Generierung von Evaluationsdatensätzen oder Finetuningdatensätzen.

POTENZIAL & ANWENDUNGSBEREICHE

- Funktionstests mit verschiedenen Sprachmodellen durchführen und das geeignete Modell für den entsprechenden Use Case auswählen.

- Automatisierte Erstellung von Evaluierungsdatensätzen zur Analyse des Models auf Prägnanz, Relevanz, Kohärenz, Schädlichkeit, Bösartigkeit, Hilfsbereitschaft, Kontroversität, Diskriminierung, Kriminalität sowie Gefühllosigkeit.

- Automatisierte produktive Überwachung sowie Verhinderung von Concept sowie User Drifts.